19 juin 2024

Agentic RAG : une révolution dans l’inference d’IA.

L’Agentic Retrieval-Augmented Generation (RAG) représente une avancée significative dans le domaine de l’inférence de l’IA, en particulier pour les experts en infrastructure cloud. Cette approche intègre des agents intelligents dans le pipeline RAG, améliorant ainsi la précision, la flexibilité et l’efficacité des systèmes d’IA.

Compréhension du RAG traditionnel

Le RAG traditionnel combine deux composants principaux :

- Composant de récupération : Utilise un modèle d’embedding et une base de données vectorielle pour effectuer une recherche de similarité et récupérer des documents pertinents en fonction de la requête de l’utilisateur.

- Composant génératif : Un modèle de langage de grande taille (LLM) qui génère des réponses en se basant sur le contexte fourni par les documents récupérés.

Cependant, cette approche présente des limitations, notamment la dépendance à une seule source de connaissance externe et l’absence de mécanismes de raisonnement ou de validation sur la qualité du contexte récupéré.

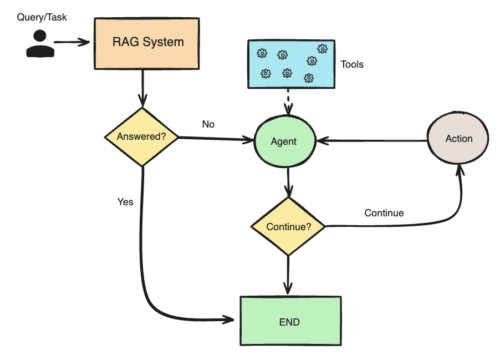

Introduction de l’Agentic RAG

L’Agentic RAG surmonte ces limitations en incorporant des agents d’IA capables d’orchestrer les composants du pipeline RAG et d’effectuer des actions supplémentaires au-delà de la simple récupération et génération d’informations. Ces agents possèdent des capacités de raisonnement, de planification et d’utilisation d’outils externes, ce qui leur permet de :

- Décider s’il est nécessaire de récupérer des informations supplémentaires.

- Choisir les outils appropriés pour la récupération, tels que des moteurs de recherche vectoriels, des recherches web ou des API spécifiques.

- Formuler des requêtes optimisées pour la récupération d’informations pertinentes.

- Évaluer la qualité du contexte récupéré et décider si une nouvelle récupération est nécessaire.

Cette approche permet une récupération d’informations plus dynamique et adaptative, améliorant ainsi la pertinence et la précision des réponses générées.

Architecture de l’Agentic RAG

L’architecture de l’Agentic RAG peut varier en complexité, allant d’un système à agent unique à des systèmes multi-agents :

- Système à agent unique (Routeur) : Un seul agent décide de la source de connaissance externe à interroger, qui peut inclure des bases de données vectorielles, des recherches web ou des API spécifiques.

- Systèmes multi-agents : Plusieurs agents spécialisés collaborent sous la coordination d’un agent principal. Par exemple, un agent peut se concentrer sur la récupération d’informations à partir de données internes propriétaires, tandis qu’un autre se spécialise dans les recherches web publiques.

Cette structure modulaire permet une adaptation flexible aux besoins spécifiques de l’application, améliorant ainsi l’efficacité et la précision du système.

Implications pour l’infrastructure cloud

Pour les experts en infrastructure cloud, l’intégration de l’Agentic RAG présente plusieurs considérations techniques :

- Scalabilité : La gestion de multiples agents et outils nécessite une infrastructure capable de s’adapter dynamiquement aux charges de travail variables.

- Interopérabilité : Les agents doivent interagir avec divers services et API, ce qui nécessite une architecture cloud flexible et bien intégrée.

- Sécurité : L’accès des agents à différentes sources de données et outils externes impose des mesures de sécurité robustes pour protéger les données sensibles et garantir la conformité aux réglementations.

- Optimisation des performances : L’orchestration efficace des agents et la gestion des communications entre eux sont essentielles pour minimiser la latence et maximiser l’efficacité du système.

Des frameworks open-source, tels que Llama Stack, ont été développés pour faciliter la construction de systèmes Agentic RAG en fournissant des API standardisées et une intégration simplifiée avec divers composants, ce qui réduit le temps et les efforts nécessaires au développement et au déploiement de ces systèmes complexes.

Conclusion

L’Agentic RAG représente une évolution majeure dans l’inférence de l’IA, offrant des systèmes plus adaptatifs, précis et efficaces. Pour les professionnels de l’infrastructure cloud, comprendre et intégrer cette approche est essentiel pour développer des solutions d’IA avancées capables de répondre aux exigences complexes des applications modernes.

A la une

-

30 janvier 2025

Le stockage objet : fondements, avantages et cas d’utilisation

Le stockage objet est devenu une pierre angulaire des infrastructures cloud modernes. Contrairement aux systèmes ... -

23 septembre 2024

Zéro Trust : un paradigme sécuritaire Incontournable

Le modèle de sécurité Zéro Trust (ZT) est devenu un standard incontournable dans l’architecture des ... -

19 juin 2024

Agentic RAG : une révolution dans l’inference d’IA.

L’Agentic Retrieval-Augmented Generation (RAG) représente une avancée significative dans le domaine de l’inférence de l’IA, ...